Segunda-feira, 23 de dezembro de 2024

Segunda-feira, 23 de dezembro de 2024

Por Redação Rádio Pampa | 4 de junho de 2023

A inteligência artificial (IA) pode levar a humanidade à extinção, alertaram especialistas — incluindo os chefes da OpenAI e do Google Deepmind. Dezenas apoiaram uma declaração publicada na página do Center for AI Safety (ou Centro de Segurança de Inteligência Artificial, em tradução livre), ong de pesquisa e desenvolvimento com sede em São Francisco, nos Estados Unidos.

“Mitigar o risco de extinção pela IA deve ser uma prioridade global, juntamente com outros riscos em escala social, como pandemias e guerra nuclear”, aponta a carta aberta. Mas outros dizem que os medos são exagerados.

Sam Altman, executivo-chefe da OpenAI, fabricante do ChatGPT, Demis Hassabis, executivo-chefe do Google DeepMind e Dario Amodei, da Anthropic, apoiaram a declaração.

O texto do Center for AI Safety sugere uma série de possíveis cenários de desastre:

– As IAs podem ser armadas — por exemplo, com ferramentas para descobrir drogas que podem ser usadas na construção de armas químicas;

– A desinformação gerada pela IA pode desestabilizar a sociedade e “minar as tomadas de decisões coletivas”;

– O poder da IA pode se tornar cada vez mais concentrado em poucas mãos, permitindo que “regimes imponham valores restritos por meio de vigilância generalizada e censura opressiva”;

– Enfraquecimento, a partir do qual os humanos se tornam dependentes da IA, “num cenário semelhante ao retratado no filme Wall-E”.

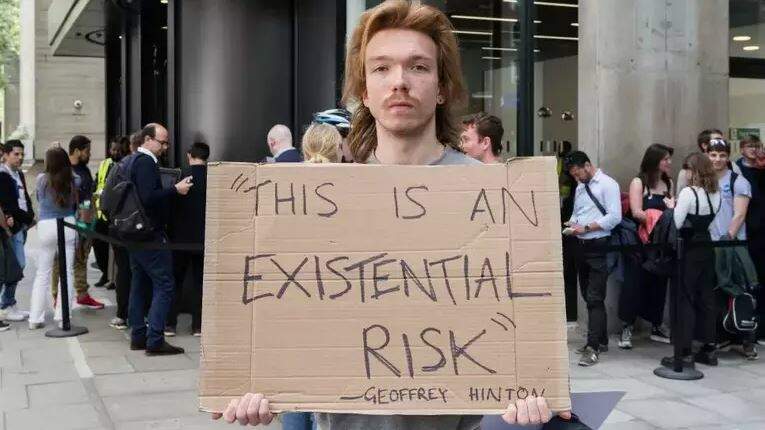

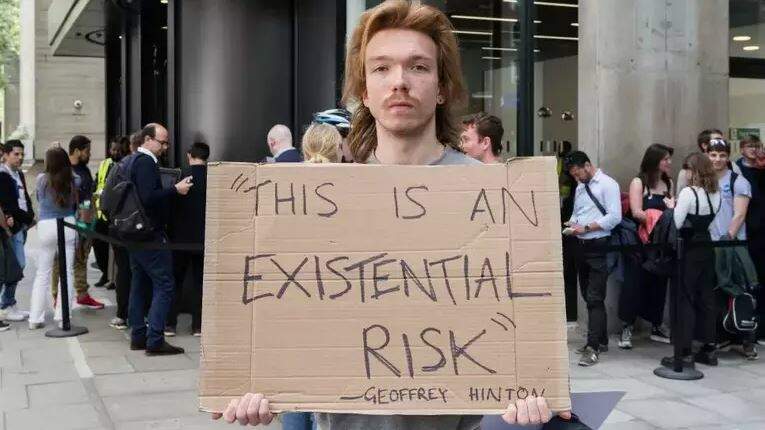

Geoffrey Hinton, que emitiu um alerta anterior sobre os riscos da IA superinteligente, também apoiou a carta do Center for AI Safety. Yoshua Bengio, professor de Ciências da Computação na Universidade de Montreal, no Canadá, também assinou o manifesto. Hinton, Bengio e o professor da Universidade de Nova York (NYU), Yann LeCunn, são frequentemente descritos como os “padrinhos da IA” pelo trabalho inovador que fizeram neste campo — e pelo qual ganharam juntos o Prêmio Turing de 2018, que reconhece contribuições excepcionais na ciência da computação.

Mas o professor LeCunn, que também trabalha na Meta, empresa dona do Facebook, disse que esses avisos apocalípticos são “exagerados” e que “a reação mais comum dos pesquisadores de IA a essas profecias de destruição é embaraçosa”.

Muitos outros especialistas também acreditam que o medo de a IA acabar com a humanidade é irreal e uma distração de questões como preconceito em relação aos sistemas, que já são um problema.

Arvind Narayanan, um cientista da computação da Universidade de Princeton, nos EUA, disse que os cenários de desastre de ficção científica não são realistas. “A IA atual não é nem de longe suficientemente capaz para que esses riscos se materializem. Como resultado, isso desvia a atenção dos danos de curto prazo da IA”, avalia ele.

Elizabeth Renieris, pesquisadora sênior do Instituto de Ética em IA da Universidade Oxford, no Reino Unido, disse à BBC News que se preocupa com os riscos mais próximos.

“Os avanços na IA ampliarão a escala da tomada de decisão automatizada que é tendenciosa, discriminatória, excludente ou injusta. Ao mesmo tempo em que é inescrutável e incontestável”, acredita ela.

Estes avanços “podem impulsionar um aumento exponencial no volume e na disseminação de desinformação, fraturando assim a realidade e corroendo a confiança do público, além de gerar mais desigualdade, principalmente para aqueles que permanecem do lado errado da divisão digital”.

Muitas ferramentas de IA essencialmente “pegam carona” em “toda a experiência humana até o momento”, destaca Renieris.

Várias dessas tecnologias são treinadas em conteúdo, texto, arte e música criados por humanos — e seus criadores “transferiram efetivamente uma tremenda riqueza e poder da esfera pública para um pequeno punhado de entidades privadas”.